大模型行业越来越热闹。国外,马斯克为Twitter抢购1万块GPU筹备大模型项目、亚马逊大力投资大型语言模型和生成式AI、OpenAI推出了ChatGPTiOS版本;国内,百度发布文心一言、阿里发布通义千问,王小川、王慧文、闫俊杰等“有背景”的创业者跑步进场。

相较于深度学习而言,大模型让AI的认知能力更上一层楼,进而实现所谓的“智能涌现”,催生出ChatGPT、AutoGPT、AIGC等新型应用,让AI全面进入工业化大生产阶段。英伟达创始人、CEO黄仁勋说:AI的“iPhone时刻”来临。在激动人心的“iPhone时刻”,行业缺什么?

百模大战

AI的门槛一下变高了

跟当年的AI创业以及互联网创业生态不同,大模型成为“头号玩家”的游戏,活跃的玩家要么是大厂,要么是有资金加持的“有背景”创业者,“草根创业者”尚未出现。

大模型具有“巨量数据、巨量算法、巨量算力”三大“巨量”特征,对任何企业包括巨头来说,打造一个大模型都不是一件容易的事情,需要收集海量数据、需要采买海量算力、需要进行大量研发,金钱、时间、人力投入同样“巨量”。ChatGPT是创业公司OpenAI做的,这家公司在2015年成立后低调耕耘8年,且有微软等巨头/大佬支持,底层硬件投入高达10亿美元以上,每次训练消耗的电力足够3000辆特斯拉汽车每辆跑20万英里。

“巨量”特征让大模型研发门槛极高,但任何技术生态要走向繁荣都离不开社会化创新。移动互联网的崛起源自于iOS和安卓的出现,但也离不开应用市场数百万开发者的创新。同理,大模型上“长出”的应用也都得靠开发者来定义,让AI大模型为所有开发者(技术服务商、企业、组织、个体开发者等)所用,是加速大模型产业发展的关键。

截至目前,大模型还处在“只听其声不闻其人”的阶段,大厂的大模型已在开放,但需要使用者有较高的人才、算力等资源配置,当下市面上急缺一款让开发者乃至大学生等群体“人人可用”的大模型。

62亿参数规格

大模型也能“小而美”

最近我在朋友圈看到有人分享了一个轻量级开源大模型:中英双语对话模型ChatGLM-6B,它的最大特点是轻量化,支持在单张消费级显卡上进行部署推理使用,这让它具备人人可用的基础——千亿规格的大模型往往需要成百上千张显卡才能部署。

ChatGLM-6B来自智谱AI这家公司,它由清华技术成果转化而来。2022年8月,智谱AI旗下的千亿级参数模型GLM-130B中英双语稠密模型正式向研究界和工业界开放——“130B”是130billion的缩写,即1300亿参数。据官网介绍称,GLM-130B与BERT、GPT-3和T5有着不同的架构,是一个包含多目标函数的自回归预训练模型,具有双语支持、高精度和快速推理等特性。

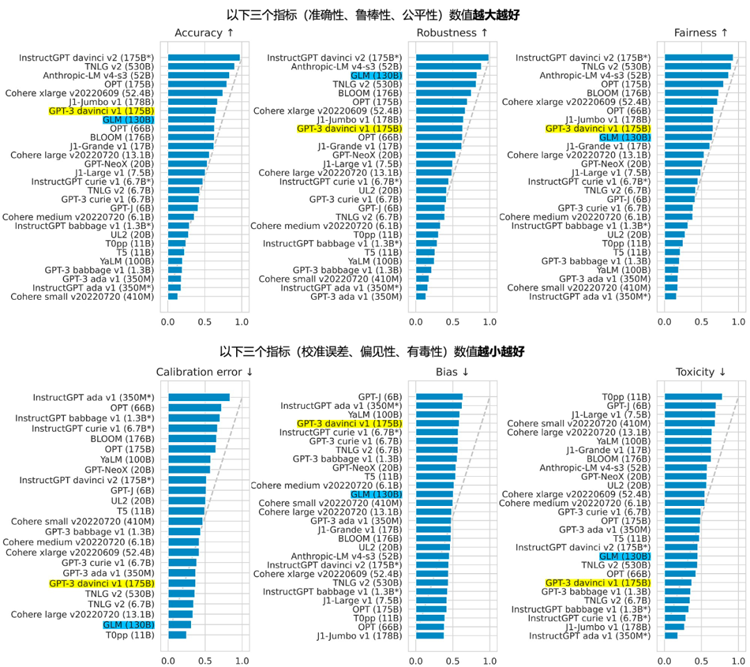

2022年11月,斯坦福大学大模型中心对全球30个主流大模型进行了全方位的评测,GLM-130B是亚洲唯一入选的大模型。在与OpenAI、谷歌大脑、微软、英伟达、脸书的各大模型对比中,评测报告显示GLM-130B在准确性和恶意性指标上与GPT-3175B(davinci)接近或持平,鲁棒性和校准误差在所有千亿规模的基座大模型(作为公平对比,只对比无指令提示微调模型)中表现不错。

2023年3月14日,智谱AI基于GLM-130B推出的千亿对话模型ChatGLM开始内测,ChatGLM对标ChatGPT,具备问答和对话功能且针对中文进行了优化,第三方评测显示其具备ChatGPT3.5至少70%的能力水平。同一天,智谱AI还开源了62亿参数的ChatGLM-6B模型。根据官方Blog显示,ChatGLM-6B采取跟GLM-130B一样的架构与技术,其将参数规格从千亿精简到62亿,具有如下特征:

第一,轻量级。结合模型量化技术,ChatGLM-6B参数大幅精简,INT4量化级别下最低只需6GB显存,支持在单张消费级显卡上进行本地部署,部署门槛与推理成本大幅降低。

第二,中英双语对话。进行了充分的中英双语预训练,经过约1T标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等训练方式,它更能对齐人类意图,进而拥有不错的智能表现。

第三,国产自主。GLM-130B对国产信控生态有较好的支持,可在国产的海光DCU、华为昇腾910和申威处理器及美国的英伟达芯片上进行训练与推理。ChatGLM-6B作为国产自主的轻量级大模型也支持信控平台,可助力我国AI技术特别是大模型自主化。

截至目前ChatGPT、文心一言、通义千问的体验门槛都很高,而ChatGLM-6B支持公众体验(http://open.bigmodel.ai/trialcenter),简单注册后,我体验了一下它的能力。对近期AI型圈沸沸扬扬的口水战,它回答得很得体。

我打算做一个华为最新折叠屏手机MateX3的评测,让ChatGLM-6B帮忙写一个提纲,结果中规中矩,思路没问题:

写诗这样的常规任务不在话下。

商业文案创作比如取名、想广告词都可以做,“喝蜜雪,不舔盖”,很有创意了。

体验中大部分时候ChatGLM-6B的表现相比ChatGPT、文心一言、通义千问并不逊色,考虑到它是一个只有62亿参数的“轻量版”大模型,哪怕“逊色”也都可以原谅了。特别值得一提的是,智谱AI针对取标题、写文章等不同场景进行了调优,让它在满足对应AIGC需求时有更出色的表现。

ChatGLM-6B的参数规格只有62亿,因此也存在一些不容回避的问题,比如在面对许多事实性知识任务时可能会生成不正确的信息,不擅长逻辑类问题(如数学、编程)的解答,对多轮对话的支持很一般。

要真正拥有人的智商,AI大模型依然任重道远。AI大模型的完整称呼是“AI预训练大模型”,“预训练”的字面意思很容易理解:预先训练好,这样应用开发者可得到相对现成的训练结果,基于此直接开发AI应用,不再需要从0到1训练数据、建立模型。它通过堆叠数据集“贪婪式”地训练模式,拥有较强的通用性,理论上可泛化到多种应用场景,而小样本或零样本的技术实现,则可让应用开发者快速基于其构建工程应用。

显而易见,ChatGLM-6B的出现体现出了大模型预训练与泛化通用的精髓,它的理念是“有舍才有得”,弱化一些能力,但降低了部署门槛,让开发者、研究者在本地计算机上进行大模型的微调、部署、训练成了可能,进而可更好地支持大模型落地到海量场景。

在前几天的一次公开活动上,智谱AICEO张鹏曾表达一个观点,“AIGC产业基座是预训练大模型,原因在于两个方面:第一、通用泛化能力,为AI研发降本增效,这是非常关键的特性;第二,融入更多知识,让大模型能更好模拟人的智能。但与此同时也面临着一些挑战,比如成本高昂、训练数据巨大,周期长等。”ChatGLM-6B的开源正是智谱AI实现通用泛化、降低AI研发门槛与成本的实践。

开源一个月后,ChatGLM-6B的Huggingface全球下载量已超过75万,持续两周位列Huggingface全球模型趋势榜榜首,GitHub星标数达到1.7万。“小而美”的ChatGLM-6B在开源社区走热是大模型热的缩影。

ChatGLM-6B让大模型技术“人人可用”

ChatGLM-6B通过轻量化的模式实现大模型的通用泛化,解决了大模型“高不可攀”这一开发者的痛点。在日益蓬勃的大模型产业中,有着独特占位的ChatGLM-6B将在AI技术普惠中扮演重要角色。具体来说,它将给大模型产业带来如下好处:

1、降低大模型使用门槛。更多开发者可轻松部署大模型,一方面,ChatGLM-6B是开源的,开发者可深入大模型底层一探究竟,只有搞清楚大模型的运转机制才能更好地利用好大模型技术。另一方面,开发者可基于ChatGLM-6B进行上层应用创新,开发出我们今天想都想不到的创新AI应用,在工业化阶段再切换到GLM-130B这样的千亿级大模型上。

2、降低大模型的训练成本。大模型训练成本高昂且耗能,基于开源的ChatGLM-6B,开发者不再需要搭建庞大的算力体系,在训练推理时也不需要耗费惊人的电力资源、所需时间周期将大幅缩短,进而更高效、低碳、经济地应用大模型技术,加速AI工业化大生产。

3、有利于大模型的教育普及。乔布斯当年曾说人人都要会编程,未来人人则要学会使用AI工具。在教育场景,计算机相关专业的大学生以及对编程有兴趣的青少年,只要有一台搭载显卡的计算机就能轻松地部署ChatGLM-6B,可以尽早了解并学会应用大模型这一基础技术。

个人觉得,“ChatGLM-6B+GLM-130B”的组合模式给AI大模型产业落地提供了一个新的范式:轻量级大模型扮演普惠的角色,让更多人轻松“入门”,学习、理解、熟悉大模型技术,进行创新应用的开发、验证、测试等。到了应用阶段,如有必要再使用GLM-130B这样的千亿级工业化大模型部署产品,面向客户与用户提供商业化服务。

写在最后:

AI大模型技术掀起新一轮产业革命,人类社会的生产力、生产资料与生产关系都将被重新定义,人们的生活与工作方式、企业的经营模式以及社会的治理方式都在被重构。在这样的大变局下,AI大模型已成为“国之重器”。

在技术浪潮涌来时,国际形势正波诡云谲,大国竞争日益激烈,科技是核心角力场,不论是十四五规划纲要还是二十大均明确要增强科技创新引领作用,实现高水平科技自立自强。在这样的时代背景下,大模型成了跟芯片一样的制高点,我国必须要有自己的底层大模型技术,更需要有自己的完整的大模型应用与产业生态。

这几天,王小川与百度的口水战在大模型行业引发热议,其实争论“我国大模型距离ChatGPT的差距究竟是2个月还是2年”没什么意义,我国大模型技术距离GPT还有客观的差距,推动大模型技术精进和产业落地,是大模型玩家们的责任,行业更需要ChatGLM-6B这样的可落地的解决方案,它大幅降低了AI开发门槛,未来还可结合低代码等技术实现“人人都会大模型开发”,这才是AI大模型技术普惠的必经之路,也是我国AI大模型实现赶超的关键。

在官方博客上,ChatGLM团队有一段朴素的文字:

“我们一直在探索、尝试和努力,GLM系列模型取得了一丝进展,但我们离国际顶尖大模型研究和产品(比如OpenAI的ChatGPT及下一代GPT模型)都还有明显差距。中国大模型研究在原创算法、AI芯片和产业上的追赶与突破需要大家的一起努力,更需要我们对下一代AI人才的培养与锻炼。很幸运的是,GLM团队在过去几年探索的过程中,有一群有情怀、有能力、有格局的年轻人加入我们并肩作战,快乐开卷,大家一起焦虑,一起熬夜,一起成长,一起创造。通用人工智能探索,我们一直在路上,努力前行。”

我觉得还是很扎心的。大模型热潮中,浑水摸鱼、蹭热点、搞炒作的玩家不少,但也有一些脚踏实地的团队正在研发大模型技术,想方设法在推动大模型落地,只争朝夕地追赶先行者,他们,值得被尊敬。